In der modernen Hochschulbildung ist die Optimierung und Personalisierung des Lernprozesses von entscheidender Bedeutung. Besonders in komplexen Bereichen wie den Bildungswissenschaften können Technologien wie Large Language Models (LLMs) und Retrieval Augmented Generation (RAG) eine unterstützende Rolle spielen. Das Projekt BiWi AI Tutor zeigt, wie diese Technologien erfolgreich in Form eines KI-Chatbots eingesetzt werden können, um das Lernerlebnis für Studierende im Kurs Bildungswissenschaften (BiWi) an der Universität Leipzig zu verbessern.

Über den BiWi AI Tutor Chatbot

Der BiWi AI Tutor ist ein intelligenter Chatbot, der entwickelt wurde, um Studierende im Kurs der Bildungswissenschaften durch präzise, kontextbewusste Antworten auf ihre Fragen zu unterstützen. Er nutzt fortschrittliche Sprachmodelle und Dokumentenabrufsysteme, um das Lernerlebnis zu verbessern, selbstgesteuertes Lernen zu fördern und skalierbare Bildungsunterstützung zu bieten. Das öffentliche Code-Repository des Projekts ist hier zugänglich.

Verständnis von Large Language Models und Retrieval Augmented Generation

Large Language Models (LLMs) sind fortschrittliche KI-Systeme, die auf umfangreichen Textdaten trainiert wurden. Sie können menschliche Sprache verstehen und generieren, was sie in die Lage versetzt, sinnvolle Gespräche zu führen, Fragen zu beantworten und Erklärungen basierend auf den erhaltenen Eingaben zu liefern.

Retrieval Augmented Generation (RAG) kombiniert traditionelle Dokumentenabruftechniken mit den generativen Fähigkeiten von LLMs. Dieser Ansatz ermöglicht es dem System, auf ein großes Dokumentenarchiv zuzugreifen und spezifische Informationen zu nutzen, um präzise und kontextuell relevante Antworten zu generieren. Dadurch sind die Antworten nicht nur kohärent, sondern auch fundiert und zuverlässig.

Schlüsselfunktionen

- Intelligenter Chatbot: Nutzt LangChain und LangGraph, um komplexe Anfragen zu bearbeiten und nuancierte Antworten zu liefern.

- Dokumentenabruf: Ruft Kursmaterialien ab und verarbeitet diese, um kontextbewusste Antworten zu bieten.

- Unterstützung mehrerer Modelle: Integriert mehrere Modelle, einschließlich OpenAI’s GPT-3.5-turbo für die Antwortgenerierung und GPT-4 für die Bewertung, sowie Cohere’s Reranker-Modelle.

- Benutzerfreundliche Oberfläche: Bietet eine Chatbot-Oberfläche, die mit Mentoring Workbench erstellt wurde, für nahtlose Interaktionen.

- API-Zugang: Stellt Flask-basierte API-Endpunkte bereit, um den Chatbot in andere Anwendungen zu integrieren.

- Evaluierungstools: Enthält Skripte zur Bewertung der Leistung des Chatbots anhand vordefinierter Datensätze, die von Fachexperten erstellt wurden.

Verwendete Technologien

Der BiWi AI Tutor wurde unter Verwendung einer Kombination aus modernsten Technologien und Tools entwickelt:

- Sprachmodelle: Nutzt OpenAI’s GPT-3.5-turbo für das Verständnis und die Generierung natürlicher Sprache sowie GPT-4 zur Bewertung der Antworten.

- LangChain und LangGraph: Rahmenwerke, die die Integration von Sprachmodellen mit verschiedenen Datenquellen und Tools erleichtern.

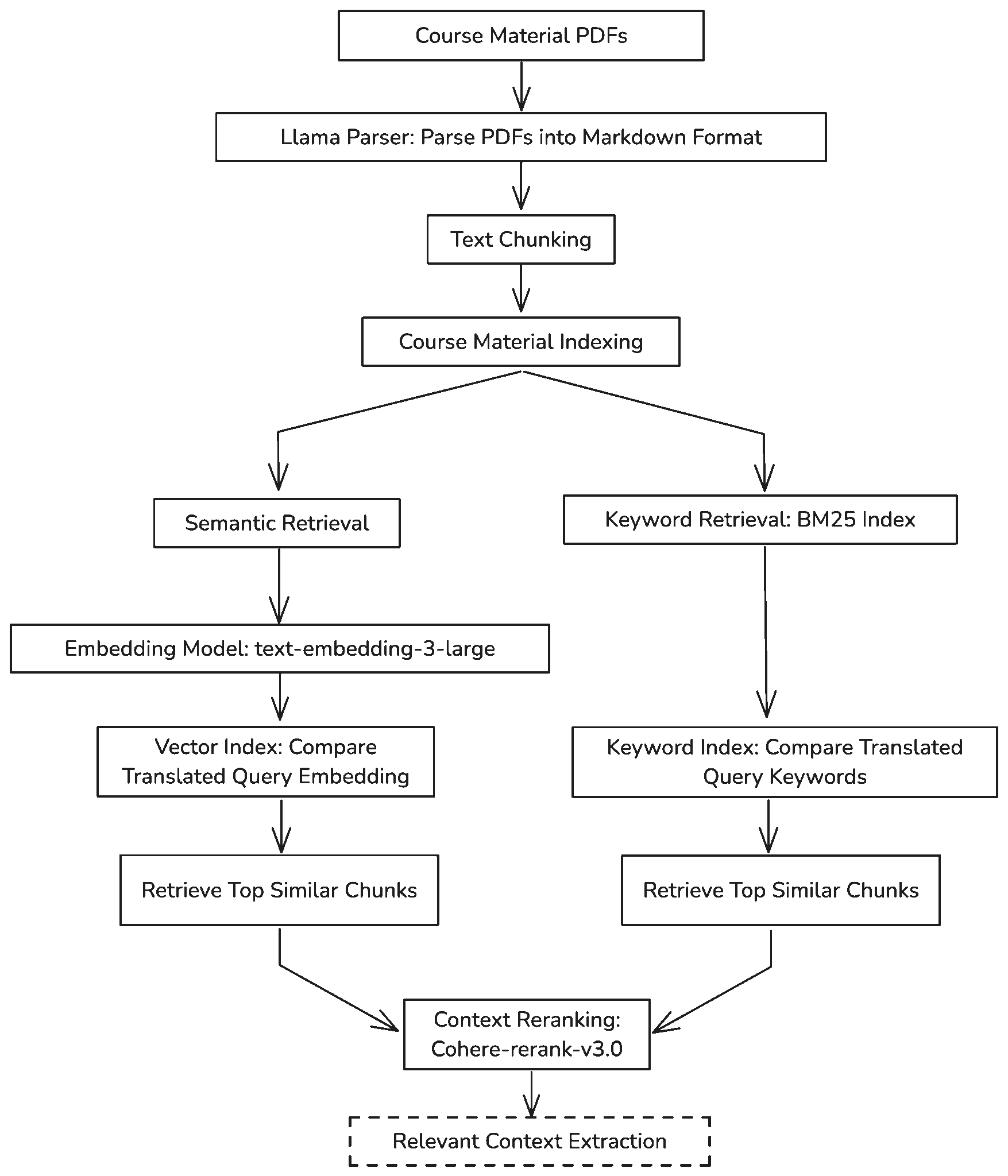

- Retrieval-Systeme: Implementiert hybride Abrufmechanismen unter Verwendung von Vektor-Embeddings und BM25-Indizes für eine effiziente Informationsbeschaffung.

- Cohere Reranker-Modelle: Setzt Cohere’s Reranker-Modelle ein, um die Relevanz des abgerufenen Kontexts zu verbessern.

- Web-Technologien: Entwickelt mit Flask für API-Endpunkte und Mentoring Workbench für die Benutzeroberfläche, was eine reaktionsschnelle und benutzerfreundliche Erfahrung gewährleistet.

- Docker: Containerisierung mit Docker für eine einfache Bereitstellung und Skalierbarkeit.

Wie funktioniert der Chatbot?

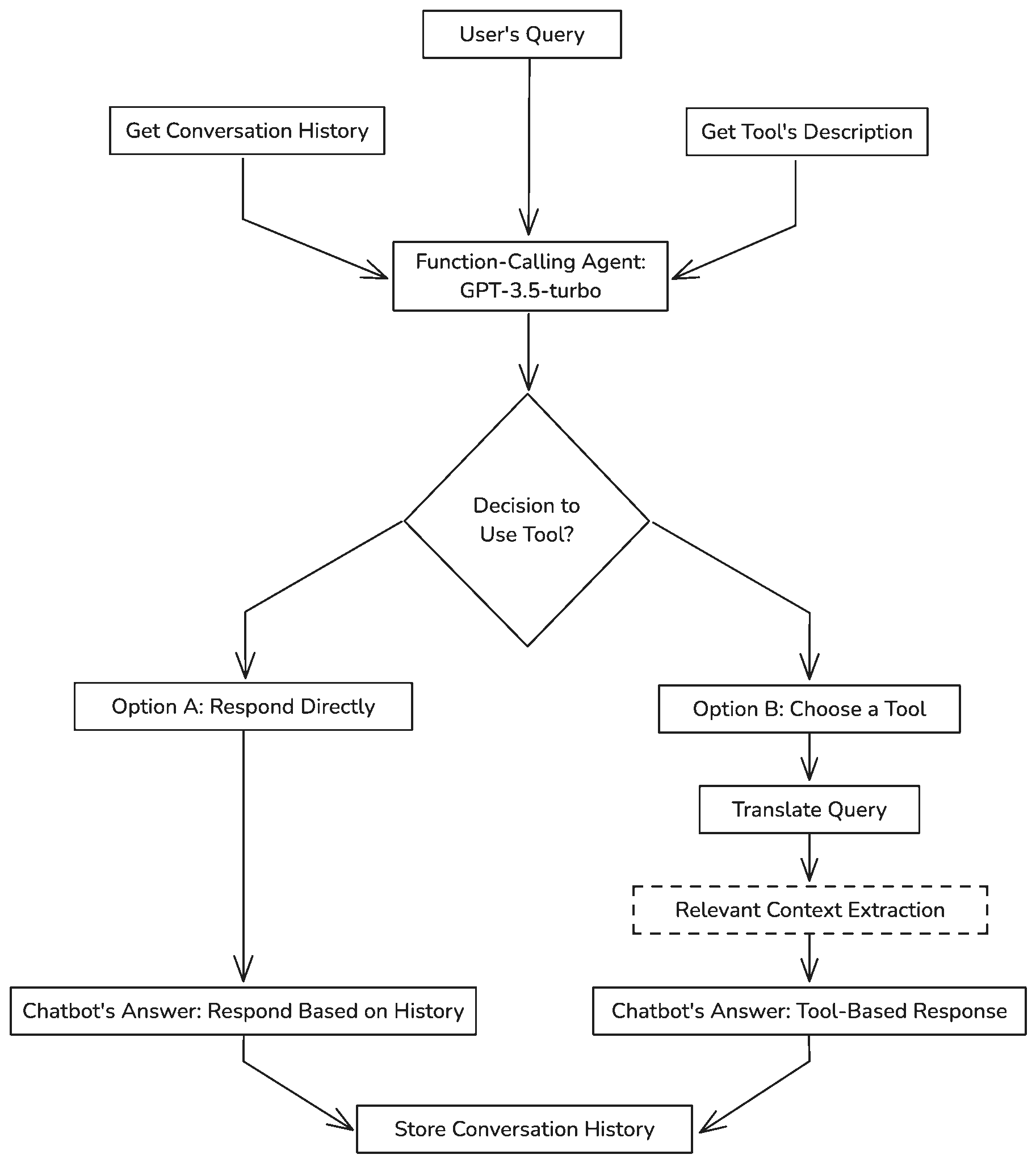

Der KI-basierte Chatbot nutzt fortschrittliche Sprachmodelle, die mit Retrieval Augmented Generation (RAG) Techniken verbessert wurden, um kontextbewusste und präzise Antworten auf die Fragen der Studierenden zu liefern. Der Prozess umfasst mehrere Schritte:

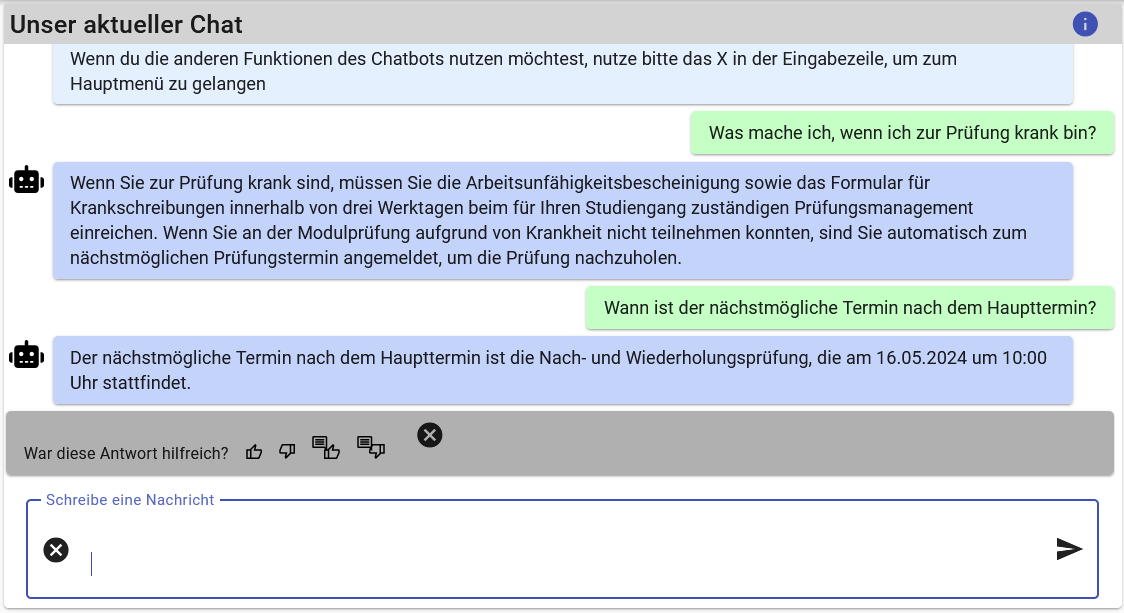

- Fragenstellung: Studierende stellen eine Frage zu ihrem Kursmaterial, beispielsweise: „Was mache ich, wenn ich zur Prüfung krank bin?“

- Fragenverarbeitung: Die Frage wird in Vektor-Embeddings umgewandelt, wodurch sie für das LLM lesbar und analysierbar wird.

- Hybrider Abrufmechanismus: Der Chatbot verwendet sowohl semantischen Abruf als auch schlüsselwortbasierten Abruf, um in einer indexierten Datenbank von Kursmaterialien, einschließlich Vorlesungsfolien, Seminartexten und organisatorischen Dokumenten, zu suchen.

- Kontext-Reranking: Abgerufene Informationsabschnitte werden mithilfe eines Reranker-Modells neu bewertet, um den relevantesten Inhalt für die Anfrage des Nutzers zu priorisieren.

- Antwortgenerierung: Das LLM analysiert den verfeinerten Kontext und erstellt eine präzise, kontextuell angemessene Antwort.

Indexierung des Lernmaterials

Die Effektivität des BiWi AI Tutors hängt stark von seiner Fähigkeit ab, relevante Kursmaterialien effizient abzurufen. Der Indexierungsprozess umfasst das Parsen von Kurs-PDFs in strukturierte Formate, das Aufteilen des Inhalts in handhabbare Abschnitte und das Erstellen sowohl semantischer als auch schlüsselwortbasierter Indizes. Dies stellt sicher, dass der Chatbot auf die relevantesten Teile des Kursmaterials zugreifen und diese nutzen kann, um genaue Antworten zu liefern.

Interaktionsfluss des Chatbots

Der Interaktionsfluss des Chatbots stellt sicher, dass Studierende genaue und zeitnahe Antworten erhalten. Vom Empfang einer Anfrage bis zur Generierung einer Antwort ist jeder Schritt sorgfältig darauf ausgelegt, Kontext und Relevanz aufrechtzuerhalten. Dieser Ablauf integriert die Indexierungs- und Abrufprozesse, um nahtlose und kontextuell reiche Interaktionen zu ermöglichen.

Evaluierung des Chatbots

Der BiWi AI Tutor wurde rigoros evaluiert, um seine Effektivität und Zuverlässigkeit sicherzustellen. Der Evaluierungsprozess umfasste sowohl automatisierte als auch manuelle Bewertungen:

Manuelle Bewertung durch menschliche Gutachter

Fünf menschliche Gutachter, alle Fachexperten und Kursleiter, bewerteten unabhängig voneinander die Antworten des Chatbots auf einen Satz von 60 Fragen. Jede Antwort wurde als korrekt oder inkorrekt bewertet, und die Mehrheitsentscheidung der Gutachter lieferte ein Konsensurteil.

Bewertungsergebnisse

| Kategorie | Gesamtanzahl Fragen | Korrekte Antworten (Mehrheitsentscheidung) |

|---|---|---|

| Vorlesung | 20 | 16 (80%) |

| Seminar | 20 | 15 (75%) |

| Organisatorisch | 20 | 17 (85%) |

Automatisierte Bewertung mit GPT-4

Die zweite Bewertungsmethode nutzte das GPT-4 Modell von OpenAI, um die Korrektheit der Antworten des Chatbots zu beurteilen. Die GPT-4-Bewertung spiegelte die menschliche Einschätzung genau wider und bot eine automatisierte Möglichkeit zur Überprüfung der Antwortgenauigkeit.

Bewertungsergebnisse

| Kategorie | Gesamtanzahl Fragen | Korrekte Antworten (GPT-4) |

|---|---|---|

| Vorlesung | 20 | 17 (85%) |

| Seminar | 20 | 15 (75%) |

| Organisatorisch | 20 | 17 (85%) |

Vergleich und Analyse

Der Vergleich zwischen den Mehrheitsentscheidungen der menschlichen Gutachter und den Bewertungen von GPT-4 zeigte eine enge Übereinstimmung, insbesondere bei organisatorischen Fragen, bei denen beide Bewertungen eine Korrektheitsrate von 85% erreichten.

| Kategorie | Gesamtanzahl Fragen | Korrekte Antworten (GPT-4) | Korrekte Antworten (Mehrheitsentscheidung) |

|---|---|---|---|

| Vorlesung | 20 | 17 (85%) | 16 (80%) |

| Seminar | 20 | 15 (75%) | 15 (75%) |

| Organisatorisch | 20 | 17 (85%) | 17 (85%) |

Auswirkung der Verwendung von Rerankern

Die Integration von Reranker-Modellen verbesserte die Leistung des Chatbots erheblich. Insbesondere verbesserte der Reranking-Mechanismus die Genauigkeit der Antworten bei organisatorischen Fragen, indem eine Korrektheitsrate von 100% erreicht wurde. Diese Verbesserung unterstreicht die Effektivität von Rerankern bei der Filterung und Priorisierung des relevantesten Kontexts zur Generierung genauer Antworten.

| Kategorie | Gesamtanzahl Fragen | GPT-3.5-turbo (Ohne Reranker) | GPT-3.5-turbo (Mit Reranker) |

|---|---|---|---|

| Seminar | 20 | 15 (75%) | 16 (80%) |

| Vorlesung | 20 | 17 (85%) | 16 (80%) |

| Organisatorisch | 20 | 17 (85%) | 20 (100%) |

Vorteile für Studierende und Lehrende

Chatbots wie der BiWi AI Tutor bieten verschiedene Vorteile für das Lehren und Lernen an Universitäten. Für Studierende bedeutet dies:

- Personalisierte Lernunterstützung: Studierende können individuelle Fragen stellen und erhalten maßgeschneiderte Antworten, die auf ihre spezifischen Lernbedürfnisse eingehen.

- Kontextualisierte Antworten: Der Chatbot liefert kontextbewusste Antworten, indem er vorhandene Lernmaterialien integriert, was die Relevanz und Genauigkeit der Informationen erhöht.

- Flexibilität und Skalierbarkeit: Der Chatbot ist jederzeit verfügbar und bietet über eine webbasierte Oberfläche Zugang zu wichtigen Informationen, wodurch Studierende unabhängig von ihrem Standort unterstützt werden.

Für Lehrende bringt die Kombination von LLMs und RAG folgende Vorteile:

- Skalierbare Bildungsunterstützung: Der Chatbot kann gleichzeitig zahlreiche Anfragen bearbeiten und bietet zeitnahe Unterstützung, ohne die Lehrkräfte zu überlasten.

- Einblick in die Bedürfnisse der Studierenden: Durch die Analyse häufiger Fragen können Lehrende Bereiche identifizieren, in denen Studierende Schwierigkeiten haben, und ihre Lehrmethoden entsprechend anpassen.

- Verbesserte Kursdurchführung: Die Integration von KI-Tools kann das Lernerlebnis bereichern und die Kurse interaktiver und ansprechender gestalten.

Herausforderungen beim Einsatz von LLMs

Trotz der vielen Vorteile und Möglichkeiten, die Chatbots und andere KI-basierte Lernsysteme bieten, gibt es auch Herausforderungen, die berücksichtigt werden müssen:

- Ressourcenintensiv: Der Betrieb solcher Systeme erfordert erhebliche Rechenleistung und verursacht Kosten, die mit der Verarbeitung und Wartung großer Modelle verbunden sind.

- Abhängigkeit von Anbietern: Viele dieser Systeme sind auf Schnittstellen zu externen Anbietern wie OpenAI und Cohere angewiesen, was die Autonomie der Bildungseinrichtungen einschränken kann.

- Qualität der Antworten: KI-Systeme liefern nicht immer korrekte Ergebnisse. Es kann zu „Halluzinationen“ (falschen oder unsinnigen Antworten) kommen. Die Sicherstellung der Genauigkeit der Antworten und die Minimierung von Verzerrungen, die in den Trainingsdaten vorhanden sind, sind unerlässlich.

- Datenschutzbedenken: Der Umgang mit Studentendaten erfordert die strikte Einhaltung von Datenschutzbestimmungen, um sensible Informationen zu schützen.

Fazit

Das Projekt BiWi AI Tutor zeigt, wie der Einsatz von LLMs und RAG die Hochschulbildung unterstützen kann. Durch die Integration dieser Technologien können Lernprozesse nicht nur effizienter, sondern auch flexibler und gezielter gestaltet werden.

Durch den Einsatz fortschrittlicher KI-Modelle und innovativer Abrufmethoden gewinnen sowohl Studierende als auch Lehrende neue und effektive Möglichkeiten zur Verbesserung des Lernens und Lehrens. Die Zukunft der Bildung wird somit personalisierter, skalierbarer und jederzeit zugänglich.